Apple vuole rendere Siri sempre più utile per gli utenti, anche in assenza di connessione internet, grazie alla modalità offline che l’azienda sta sviluppando e studiando per il futuro.

Attualmente, Siri lavora in questo modo: ascolta il comando vocale dell’utente quando richiesto e invia anonimamente i dati vocali ai server Apple, che converte l’audio in testo, interpreta il comando e invia il risultato all’iPhone o all’iPad dell’utente. Il processo di esecuzione del riconoscimento vocale viene quindi gestito dai server Apple, in quando si tratta di un processo molto intenso che non potrebbe essere seguito su un iPhone.

Ovviamente, la dipendenza di Siri dai server Apple significa che l’assistente virtuale può essere richiamato e utilizzato solo in presenza di connessione internet. Senza connessione, è impossibile utilizzare Siri.

Un nuovo brevetto pubblicato da Apple cerca di superare questo limite. Anziché collegarsi ai server Apple, l‘elaborazione vocale e la convalida potrebbero avvenire direttamente sul dispositivo in locale. “Ascoltando” l’utente effettuare una richiesta, il dispositivo in questione sarà in grado di determinare l’attività tramite l’elaborazione naturale del linguaggio, andando quindi ad eseguire il comando richiesto.

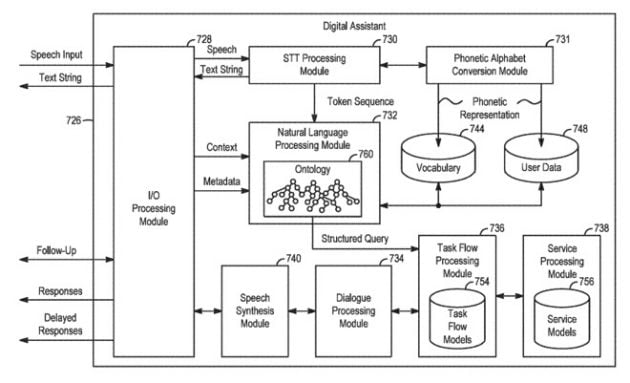

Per raggiungere questo risultato, Apple utilizza un sistema integrato di moduli per gestire le domande rivolte all’assistente virtuale. La raccolta di moduli include elementi per la sintesi vocale, l’elaborazione di dialoghi, la conversione di un alfabeto fonetico basato su un vocabolario predefinito e dati creati dall’utente, oltre ad un modulo di elaborazione del linguaggio naturale.

A seconda delle parole riconosciute e della struttura della query, l’assistente digitale offline può quindi eseguire una serie di attività predefinite memorizzate nel modulo di elaborazione del flusso di attività o nel modulo di elaborazione del servizio. Questi due flussi contengono modelli per le attività comunemente pià richieste, come l’impostazione di un timer o per riprodurre un brano salvato sul dispositivo.

Apple prevede anche l’uso di meccanismi di machine learning per eseguire specifici tipi di attività, inclusa l’elaborazione del linguaggio naturale. Tali sistemi sarebbero in grado di comprendere le informazioni contestuali, rendendole estremamente utili per determinare ciò che l’utente desidera, utilizzando una quantità limitata di dati sul dispositivo e senza dover accedere a Internet.

Avere accesso all’elaborazione locale e a quella remota fornirebbe inoltre all’assistente digitale due possibili interpretazioni delle parole pronunciate dall’utente. In tali casi, il sistema determina un punteggio di utilità per l’interpretazione elaborata localmente e per quella elaborata online, andando ad eseguire à l’attività in base al processo che ha ottenuto un punteggio più alto.

Siri offline sta per arrivare?