Giusto ieri vi abbiamo riportato che Apple stava lavorando per implementare un sistema in grado di rilevare materiale pedopornografico all’interno dei dispositivi. Nelle scorse ore, Apple ha annunciato un nuovo sistema di sicurezza per i bambini su iPhone, iPad e Mac.

AGGIORNAMENTO 9 Agosto 2021: Apple, in risposta alle varie critiche e osservazioni ricevute da parte di utenti ed esperti in tutto il mondo, ha realizzato una serie di pagine FAQ per fornire maggiori dettagli a riguardo. Da queste pagine si evincono maggiori dettagli sulla gestione del sistema di riconoscimento delle immagini e sulla privacy dell’utente; aspetto che Apple vuole sempre tutelare.

Questo sistema include nuove funzionalità di sicurezza delle comunicazioni in Messaggi, un rilevamento avanzato di materiale pedopornografico (CSAM) in iCloud e informazioni aggiornate per Siri e Ricerca. Apple sottolinea che questo sistema di sicurezza è stato realizzato perché “proteggere i bambini è una responsabilità importante”.

Nuovo sistema di sicurezza per i bambini nell’app Messaggi

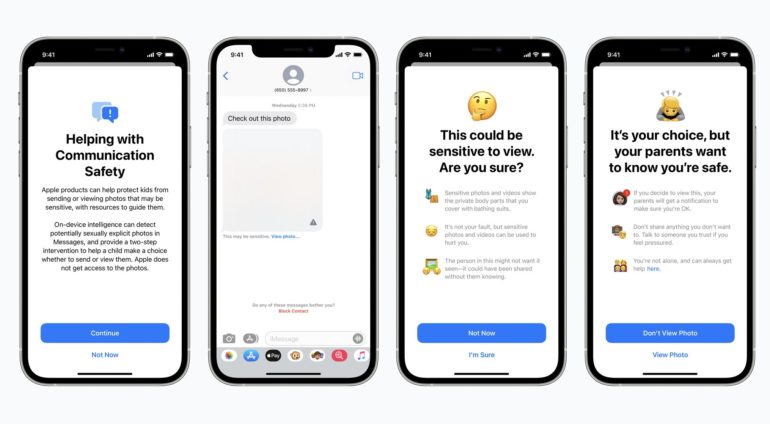

Partiamo con la nuova funzionalità di sicurezza nell’app Messaggi. Apple spiega che quando un bambino di età inferiore ai 13 anni che fa parte di una famiglia iCloud riceve o tenta di inviare foto sessualmente esplicite, il bambino vedrà l’immagine sfocata e l’app mostrerà un avviso che dice che l’immagine “potrebbe essere sensibile”. Se il bambino tocca “Visualizza foto”, vedrà un messaggio pop-up che lo informa sul motivo per cui l’immagine è considerata sensibile. Il pop-up spiega che se il bambino decide di visualizzare l’immagine, il genitore della famiglia iCloud riceverà una notifica “per assicurarsi che tu stia bene“. Il pop-up includerà anche un collegamento rapido per ricevere ulteriore assistenza.

Apple spiega inoltre che l’app Messaggi utilizzerà l’apprendimento automatico sul dispositivo per analizzare gli allegati di immagini e determinare se una foto è sessualmente esplicita. L’app manterrà la crittografazione end-to-end, per cui Apple non avrà mai l’accesso ai messaggi.

Questa funzione arriverà inizialmente negli Stati Uniti entro la fine dell’anno con iOS 15, iPadOS 15 e macOS Monterey.

Rilevamento CSAM

La seconda funzione annunciata da Apple ha il chiaro obiettivo di combattere la diffusione di materiale pedopornografico (CSAM). Apple spiega che si riferisce a contenuti che descrivono attività sessualmente esplicite che coinvolgono un bambino.

Questa funzionalità consentirà ad Apple di rilevare immagini note che contengono materiale pedopornografico quando vengono archiviate in Foto di iCloud. Apple può quindi inviare una segnalazione al National Center for Missing and Exploited Children. Si tratta di un’entità che funge da agenzia di segnalazione completa per CSAM e lavora a stretto contatto con le forze dell’ordine.

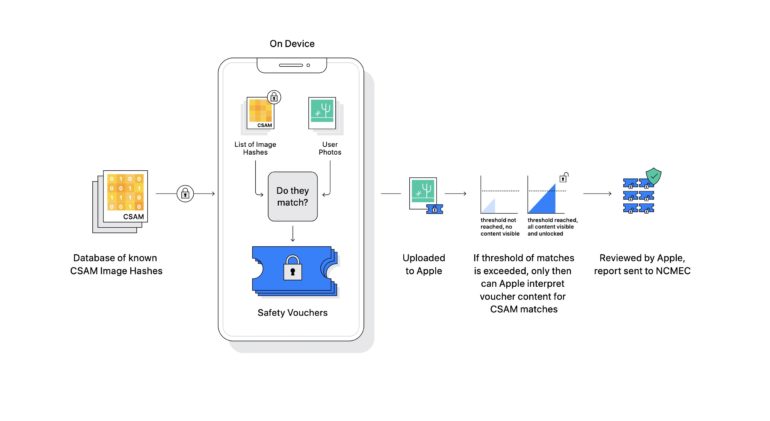

Apple sottolinea ripetutamente che il suo metodo di rilevazione è progettato tenendo presente la privacy degli utenti. In parole povere, Apple analizzerà le immagini sul tuo dispositivo per vedere se ci sono corrispondenze con un database di immagini CSAM note fornite dal National Center for Missing and Exploited Children. Tutta il processo viene eseguito sul dispositivo, infatti Apple trasformerà il database del National Center for Missing and Exploited Children in un “set illeggibile di hash archiviato in modo sicuro sui dispositivi degli utenti“.

Ma come funzionerà questo processo per la sicurezza dei bambini?

Apple spiega che prima che un’immagine venga archiviata in Foto di iCloud, viene eseguito un processo di corrispondenza sul dispositivo per quell’immagine rispetto al set illeggibile di hash CSAM noti. Questo processo di corrispondenza è alimentato da una tecnologia crittografica che determina se esiste una corrispondenza senza rivelare il risultato. Se esiste una corrispondenza, il dispositivo crea quindi un voucher di sicurezza crittografico che codifica il risultato della corrispondenza. I contenuti dei voucher di sicurezza non possono essere interpretati da Apple a meno che l’account Foto di iCloud non superi una determinata soglia di contenuto CSAM noto, anche se il limite di questa soglia non è nota.

Una volta raggiunta tale soglia, Apple esaminerà manualmente il rapporto per confermare la corrispondenza, quindi disabiliterà l’account dell’utente e invierà un rapporto al National Center for Missing and Exploited Children. Anche se tutto il processo verrà eseguito sul dispositivo, Apple analizzerà solo le immagini archiviate in Foto di iCloud. Le immagini memorizzate localmente non saranno coinvolte in questo processo.

Siri e Ricerca

Infine, Apple sta effettuando aggiornamenti per Siri e Ricerca, fornendo risorse aggiuntive per aiutare bambini e genitori a rimanere al sicuro online. Ad esempio, gli utenti che chiedono a Siri come possono segnalare CSAM o sfruttamento minorile verranno indirizzati a risorse su dove e come presentare una segnalazione.

Gli aggiornamenti a Siri e Search arriveranno entro la fine dell’anno con iOS 15, iPadOS 15, watchOS 8 e macOS Monterey.

Cosa ne pensate di questo nuovo sistema di sicurezza per i bambini che verrà implementato da Apple?

News