Apple ha fornito la sua spiegazione più completa sui motivi che hanno spinto l’azienda ad abbandonare il suo controverso piano per rilevare materiale noto di abusi sessuali su minori (CSAM) presente nelle foto di iCloud.

La dichiarazione di Apple, condivisa da Wired, è arrivata in risposta alla richiesta del gruppo per la sicurezza dei bambini Heat Initiative affinché la società “rilevi e segnali” CSAM da iCloud e offra più strumenti agli utenti per segnalare tali contenuti all’azienda.

“Il materiale pedopornografico è ripugnante e ci impegniamo a spezzare la catena di coercizione e influenza che rende i bambini suscettibili a questi abusi,” ha scritto Erik Neuenschwander, direttore della privacy degli utenti e della sicurezza dei bambini in Apple, in risposta alla Heat Initiative. Ha aggiunto, però, che dopo aver collaborato con una serie di ricercatori sulla privacy e sulla sicurezza, gruppi per i diritti digitali e sostenitori della sicurezza dei bambini, la società ha concluso che non poteva procedere con lo sviluppo di un meccanismo di scansione CSAM, nemmeno se costruito appositamente per preservare la privacy.

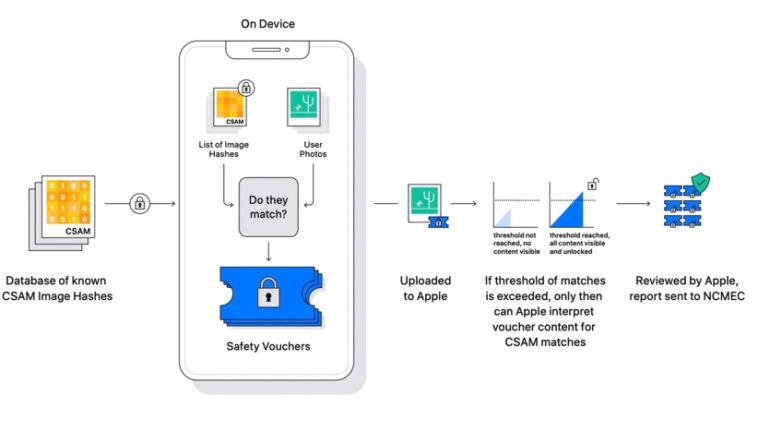

“La scansione dei dati iCloud archiviati privatamente di ogni utente creerebbe nuovi vettori di minaccia che i ladri di dati potrebbero trovare e sfruttare”, ha scritto Neuenschwander. “Inietterebbe anche il potenziale per una china pericolosa di conseguenze indesiderate. La scansione di un tipo di contenuto, ad esempio, apre le porte alla sorveglianza di massa e potrebbe creare il desiderio di cercare altri sistemi di messaggistica crittografati con vari tipi di contenuto.”

Nell’agosto 2021, Apple aveva annunciato i piani per tre nuove funzionalità di sicurezza dei bambini, tra cui un sistema per rilevare le immagini CSAM note archiviate nelle foto su iCloud, un’opzione di Communication Safety che offuscava le foto sessualmente esplicite nell’app Messaggi e risorse di tutela contro lo sfruttamento minorile in Siri.

Communication Safety è stato lanciato negli Stati Uniti con iOS 15.2 nel dicembre 2021 e da allora si è espanso nel Regno Unito, Canada, Australia e Nuova Zelanda e oggi sono disponibili anche le risorse Siri, ma il rilevamento CSAM non è mai stato lanciato.

Apple inizialmente aveva affermato che il rilevamento di materiale pedopornografico sarebbe stato implementato in un aggiornamento di iOS 15 e iPadOS 15 entro la fine del 2021, ma la società ha rinviato la funzionalità dopo aver ascoltato i “feedback di clienti, gruppi di difesa, ricercatori e altri”. I piani sono stati criticati da un’ampia gamma di esperti e organizzazioni, tra cui ricercatori di sicurezza, la Electronic Frontier Foundation (EFF), politici, ricercatori universitari e persino alcuni dipendenti Apple.

Le critiche di Heat Initiative

Dopo la risposta di Apple, Heat Initiative ha lanciato ufficialmente il sito web della sua campagna. Il gruppo di difesa dei bambini ha anche rilasciato una dichiarazione in prima pagina che recita: “Gli abusi sessuali sui minori sono archiviati su iCloud. Apple lo consente”.

“Lo storico annuncio di Apple di rilevare immagini e video di abusi sessuali su minori nel 2021 è stato silenziosamente annullato, con un impatto sulla vita dei bambini in tutto il mondo”, si legge sul sito. “Ogni giorno che passa, ci sono bambini che soffrono a causa di questa inerzia, motivo per cui chiediamo ad Apple di mantenere il proprio impegno.”

Il sito Web contiene presunti esempi che descrivono in dettaglio alcuni casi in cui iCloud è stato utilizzato per archiviare materiale relativo ad abusi sessuali, tra cui foto, video e messaggi espliciti.

Invita Apple a “rilevare, segnalare e rimuovere immagini e video di abusi sessuali da iCloud”, nonché a “creare un solido meccanismo di segnalazione affinché gli utenti possano segnalare ad Apple immagini e video di abusi sessuali su minori”.

Il gruppo ha fornito una copia di una lettera inviata direttamente a Tim Cook, in cui afferma di essere scioccata e scoraggiata dalla sua decisione di invertire la rotta e di non istituire misure di rilevamento CSAM.

Il sito include anche un tasto che consente ai visitatori di inviare un’e-mail precompilata che richiede un’azione da parte di Apple all’intero team esecutivo dell’azienda.