Apple sarebbe al lavoro su un nuovo modello d’intelligenza artificiale (AI), chiamato Ferret-UI (Furetto), utile per interpretare e comprendere il layout e il funzionamento delle applicazioni mostrate a schermo. Tutto ciò, se implementato all’interno di Siri, permetterebbe all’assistente virtuale di Apple di interagire con le app al nostro posto.

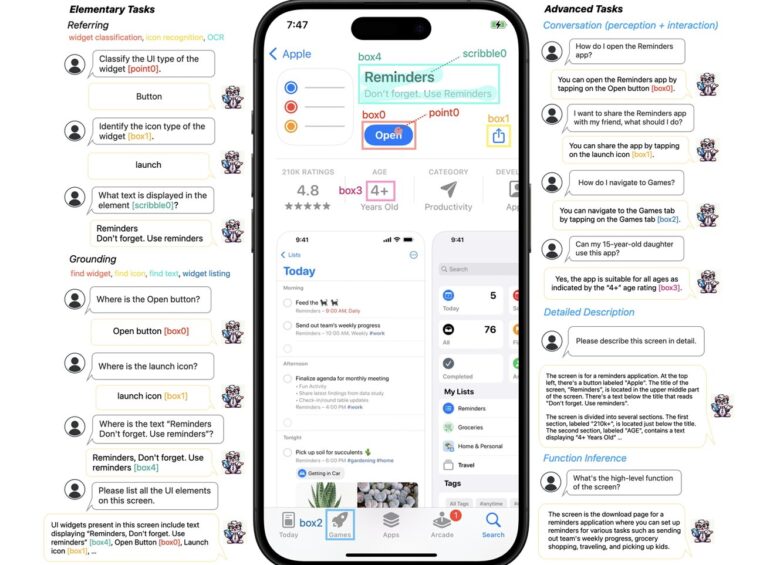

Il sistema Ferret-UI, come riporta anche AppleInsider, si sviluppa in modo da interpretare e riconoscere il layout delle app e limitare gli errori, anche tramite l’ingrandimento delle icone e delle immagini a bassa risoluzione, funzione che risulterebbe in grado di interpretare anche le icone più piccole e comprendere appieno le schermate.

Tutto questo, spiegato in parole semplici, potrebbe non solo assistere gli utenti alla ricerca di istruzioni su come usare le app all’interno del sistema, ma anche permettere a Siri di interagire con le app per conto nostro, controllandole direttamente tramite l’interpretazione della loro interfaccia.

Non sappiamo, tuttavia, quali saranno gli sviluppi futuri di tale tecnologia e quali potrebbero essere gli scenari di utilizzo di Ferret-UI, nome dato a questo modello MLLM. Tra le possibili implementazioni, non possiamo non menzionare, un miglioramento nella gestione dell’accessibilità per gli utenti ipovedenti. Vi aggiorneremo, come sempre, non appena ne sapremo di più in merito a Ferret-UI e alle migliorie che potrebbe portare su iOS e su Siri.

Infine, vi ricordiamo che il prossimo iOS 18 dovrebbe integrare numerose funzioni AI, come suggeriscono gli ultimi rumors. Ne sapremo, sicuramente, di più al keynote di apertura della WWDC 2024 in programma a Giugno.

News