La recente introduzione di Apple Intelligence nel Regno Unito ha generato un imbarazzante errore legato alla gestione delle notifiche.

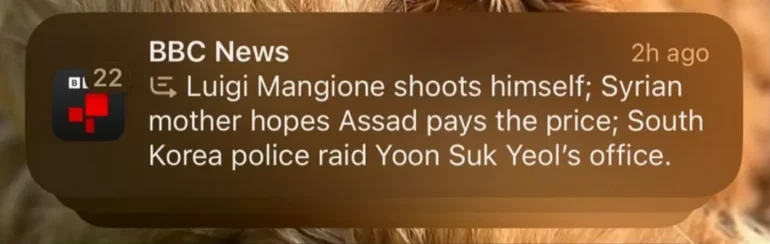

Una sintesi generata automaticamente da Apple ha distorto una notizia della BBC News, suggerendo erroneamente che Luigi Mangione, sospettato dell’omicidio del CEO di United Health, si fosse tolto la vita. La notizia era falsa e l’errore ha evidenziato i limiti dei sistemi di intelligenza artificiale generativa.

Gli errori dell’IA, come l’episodio di McDonald’s che aggiungeva centinaia di nugget agli ordini, spesso risultano divertenti. Ma alcune volte, come nei casi di indicazioni errate in situazioni di emergenza, possono essere pericolosi o, come nel caso di Apple, altamente imbarazzanti.

Apple Intelligence, pensata per riassumere notifiche e articoli, non è immune a queste problematiche. Le difficoltà nascono quando l’IA cerca di condensare ulteriormente notizie già sintetizzate, aumentando il rischio di errori interpretativi.

Sebbene gli errori dell’IA siano inevitabili, Apple potrebbe implementare filtri per notizie sensibili su temi come omicidi, crimini e disastri, richiedendo una verifica manuale per determinate keyword. Questo approccio, che comporterebbe l’assunzione di pochi revisori, rappresenterebbe un investimento minimo per evitare futuri errori che potrebbero danneggiare la reputazione del brand.

Apple si è posizionata come leader nell’innovazione, ma deve affrontare le responsabilità derivanti dall’adozione di tecnologie AI in ambiti sensibili. Nonostante il caso Mangione non abbia avuto gravi conseguenze, dimostra l’urgenza di affinare sistemi che, al momento, sembrano ancora troppo immaturi per gestire notizie critiche senza supervisione umana.