Un nuovo brevetto depositato oggi negli Stati Uniti rivela che Apple sta studiando un sistema che combina una serie di sensori laser utili per misurare la distanza di un oggetto e la sua profondità, permettendo la creazione di nuovi input virtuali su schermi desktop e mobile.

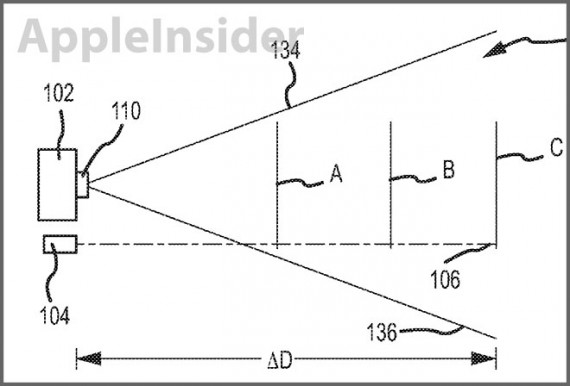

L’invenzione si intitola “Depth perception device and system” e fa uso sia dei sensori laser, sia dei sensori di immagini per determinare distanza e profondità. Come osservato nella sintesi del brevetto, il sistema può utilizzare un “raggio laser sagomato” in combinazione con un sistema di imaging, come una fotocamera digitale, per calcolare la profondità. Per funzionare, il raggio laser deve essere variato nella sa forma e intersecarsi con almeno una porzione del campo visivo della telecamera. Questa variazione consente una determinazione accurata della distanza da un oggetto, così come delle caratteristiche fisiche di tale oggetto, in base a come il laser interagisce con l’ambiente.

Poichè la luce laser si comporta in modo abbastanza prevedibile, un sensore di immagine come una fotocamera può monitorare il campo di visuale, osservando come il laser rifletta la luce sugli oggetti. Dopo che un certo numero di variabili vengono valutate, la luce riflessa viene catturata ed elaborata per determinare la profondità di ciascun oggetto. .

Il brevetto elenca una serie di scenari nei quali tale tecnologia può essere applicata. Ad esempio, il sistema può essere utilizzato per creare una rappresentazione bidimensionale della scena, o una mappa della superficie visualizzata o, ancora, la creazione virtuale di un oggetto specifico.

Andando oltre, il sistema può essere integrato in un computer, un tablet o un dispositivo mobile (Apple cita proprio l’iPhone), ad esempio per creare una tastiera laser virtuale o altri tipi di controlli virtuali. In questa forma di realizzazione, un modello di luce laser viene proiettata su una superficie e il sistema di percezione della profondità viene utilizzato per determinare la posizione delle dita di un utente.